ในโลกของการทำเว็บไซต์ให้ติดอันดับบน Google หลายคนมักให้ความสำคัญกับการเขียนเนื้อหา และการเลือกคีย์เวิร์ดเป็นอันดับแรก แต่ในความเป็นจริงแล้ว เบื้องหลังความสำเร็จของเว็บไซต์ยังมีองค์ประกอบเชิงเทคนิคที่มีบทบาทสำคัญไม่แพ้กัน หนึ่งในนั้นคือการจัดการให้ Google เข้าใจโครงสร้างเว็บไซต์ และสามารถเข้าถึงข้อมูลได้อย่างถูกต้อง และมีประสิทธิภาพ Robots.txt และ Sitemap.xml จึงกลายเป็นไฟล์พื้นฐานที่เจ้าของเว็บไซต์ และผู้เริ่มต้นทำ SEO ควรทำความเข้าใจตั้งแต่ต้น เพราะไฟล์ทั้งสองไม่เพียงช่วยควบคุมทิศทางการเก็บข้อมูลของ Google Bot แต่ยังส่งผลโดยตรงต่อการจัดทำดัชนี และการมองเห็นบนผลการค้นหา

ความเข้าใจพื้นฐานเกี่ยวกับการเก็บข้อมูลของ Google

ก่อนจะเข้าใจ Robots.txt และ Sitemap.xml จำเป็นต้องเข้าใจกระบวนการทำงานของ Google ในภาพรวมเสียก่อน Google ใช้โปรแกรมอัตโนมัติที่เรียกว่า Bot หรือ Crawler ในการเข้าไปสำรวจหน้าเว็บไซต์ต่าง ๆ บนอินเทอร์เน็ต กระบวนการนี้เรียกว่า Crawling เมื่อ Google Bot เข้าถึงหน้าเว็บแล้ว ระบบจะทำการวิเคราะห์เนื้อหา โครงสร้าง และสัญญาณต่าง ๆ ก่อนตัดสินใจนำข้อมูลเหล่านั้นไปจัดเก็บในฐานข้อมูลที่เรียกว่า Index หากหน้าใดไม่ถูก Crawl หรือไม่ถูก Index หน้านั้นก็จะไม่มีโอกาสแสดงผลบนหน้าค้นหาเลย ดังนั้นการควบคุมว่า Google ควรหรือไม่ควรเข้าไปที่หน้าใด จึงเป็นสิ่งสำคัญ

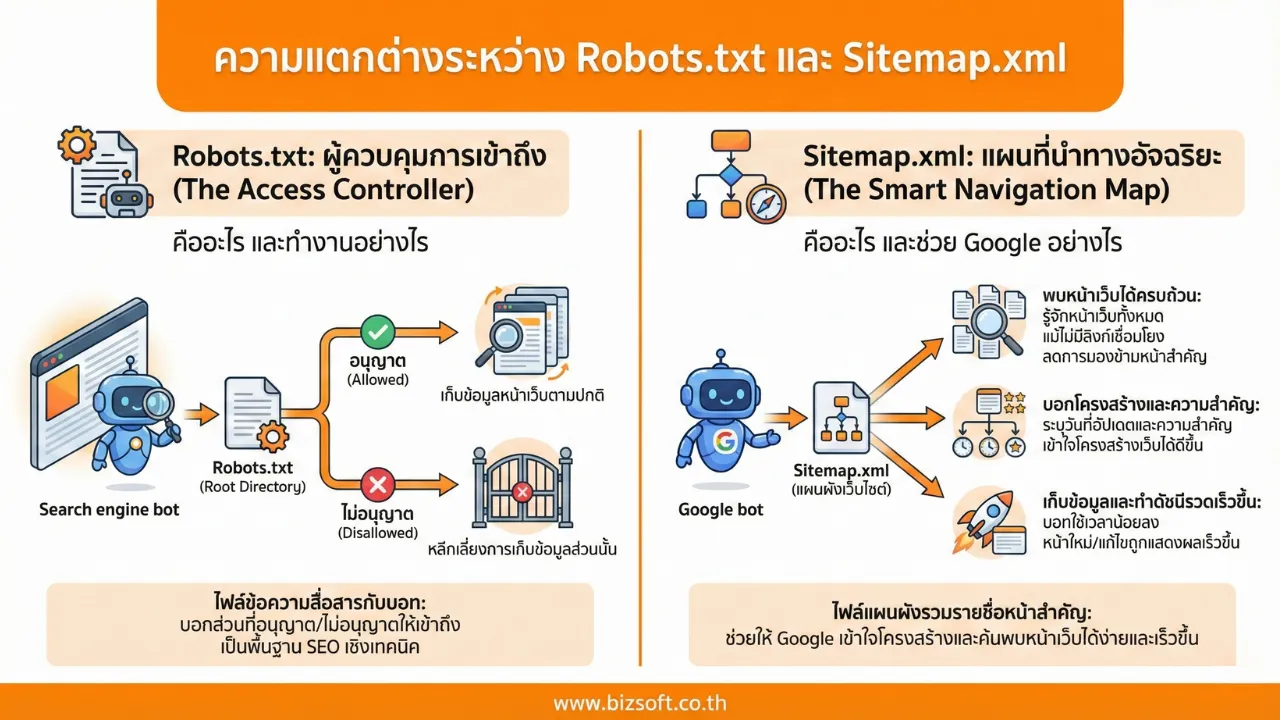

Robots.txt คืออะไร และทำงานอย่างไร

Robots.txt คือไฟล์ข้อความ (text file) ที่อยู่ใน Root Directory ของเว็บไซต์ โดยมีวัตถุประสงค์หลักเพื่อสื่อสารกับบอทของ Search Engine ว่าส่วนใดของเว็บไซต์ที่ได้รับอนุญาตให้เข้าถึงเพื่อเก็บข้อมูล และส่วนใดที่ไม่อนุญาต ถือเป็นองค์ประกอบพื้นฐานของการจัดการ SEO เชิงเทคนิคที่ช่วยให้ Search Engine เข้าใจโครงสร้างเว็บไซต์ได้ชัดเจนยิ่งขึ้น

หลักการทำงาน เมื่อบอทของ Search Engine เข้ามายังเว็บไซต์ ระบบจะตรวจสอบไฟล์ Robots.txt เป็นลำดับแรก เพื่ออ่านคำสั่งที่เจ้าของเว็บไซต์กำหนดไว้ หากพบว่าหน้าเว็บหรือโฟลเดอร์ใดถูกกำหนดไม่ให้เข้าถึง บอทจะหลีกเลี่ยงการเก็บข้อมูลในส่วนนั้น และมุ่งไปเก็บข้อมูลเฉพาะหน้าที่ได้รับอนุญาตเท่านั้น แต่ในทางกลับกัน หากไม่มีข้อห้าม Google Bot ก็จะดำเนินการ Crawl หน้าเว็บไซต์ตามปกติ

หน้าที่หลักของ Robots.txt ต่อ SEO

- ควบคุมการเข้าถึงของ Search Engine Bot: txt ช่วยกำหนดขอบเขตการทำงานของบอทจาก Search Engine ว่าควรเข้าไปเก็บข้อมูลในส่วนใดของเว็บไซต์ และส่วนใดควรหลีกเลี่ยง เพื่อให้การเก็บข้อมูลเป็นไปอย่างเป็นระเบียบ และสอดคล้องกับโครงสร้างเว็บไซต์

- ช่วยจัดลำดับความสำคัญของหน้าเว็บไซต์: การใช้ txt ช่วยลดการเข้าถึงในหน้าที่ไม่จำเป็นต่อการแสดงผลบนผลการค้นหา ทำให้ Google สามารถมุ่งเน้นการเก็บข้อมูลในหน้าหลัก หรือหน้าที่เจ้าของเว็บไซต์ต้องการให้แสดงผลมากขึ้น

- สนับสนุนการใช้ทรัพยากรการเก็บข้อมูลอย่างเหมาะสม:txt ช่วยให้ Google Bot ใช้ทรัพยากรในการ Crawl เว็บไซต์ได้อย่างเหมาะสม โดยไม่กระจายการเก็บข้อมูลไปยังหน้าที่ไม่จำเป็น

- ป้องกันการเก็บข้อมูลไฟล์ประเภทอื่น: หากเว็บไซต์ของคุณมีไฟล์ขนาดใหญ่ เช่น ไฟล์ PDF จำนวนมาก หรือไฟล์ข้อความที่ไม่ได้ส่งผลต่อการจัดอันดับ การตั้งค่า txt เพื่อไม่ให้บอทเข้าถึงไฟล์เหล่านี้ จะช่วยลดภาระของ Server และทำให้การสำรวจข้อมูลในหน้าเว็บเพจทำได้รวดเร็วยิ่งขึ้น

โครงสร้างพื้นฐานของไฟล์ Robots.txt

- User-agent: ระบุว่ากลุ่มคำสั่งนี้ใช้กับบอทตัวไหน เช่น User-agent: Googlebot สำหรับ Google แต่ถ้าใช้ User-agent: * จะหมายถึงบอททุกตัวจากทุก Search Engine ซึ่งเป็นรูปแบบที่มือใหม่มักใช้ เพราะเข้าใจง่าย และไม่ซับซ้อน

User-agent: Googlebot

User-agent: *

- Disallow: คำสั่งสำหรับบอกบอทว่า ห้าม เข้าถึงไดเรกทอรีหรือไฟล์ที่ระบุ ตัวอย่าง: Disallow: /admin/ จะหมายความว่า บอทไม่ควรเข้าไปในโฟลเดอร์ admin ซึ่งมักเป็นพื้นที่หลังบ้านหรือส่วนที่ไม่จำเป็นต้องแสดงบนผลการค้นหา

Disallow: /admin/

- Allow: คำสั่งสำหรับบอกบอทว่า อนุญาต ให้เข้าถึงไดเรกทอรีหรือไฟล์ที่ระบุ (มักใช้เพื่ออนุญาตส่วนย่อยที่ขัดแย้งกับ Disallow หลัก) ตัวอย่าง: Allow: /images/public/ อนุญาตให้เข้าถึงรูปภาพในโฟลเดอร์นี้ แม้จะถูก Disallow ภาพรวมไว้

Allow: /images/public/

- Sitemap: ระบุตำแหน่ง URL แบบเต็มของแผนผังเว็บไซต์ (Sitemap) เพื่อช่วยให้บอทค้นหาแผนผังเว็บไซต์ได้ง่ายขึ้น แม้ Google จะสามารถรับ Sitemap ผ่าน Google Search Console ได้อยู่แล้ว แต่การระบุ Sitemap ไว้ใน txt ก็ถือเป็นการย้ำข้อมูลสำคัญอีกทางหนึ่ง ช่วยให้บอทเข้าใจโครงสร้างเว็บไซต์ได้เร็ว และครบถ้วนมากขึ้น

Sitemap: https://www.example.com/sitemap.xml

Sitemap.xml คืออะไร และช่วยให้ Google เข้าใจเว็บไซต์ได้อย่างไร

Sitemap.xml คือไฟล์แผนผังเว็บไซต์ที่ใช้รวบรวมรายชื่อหน้าเว็บสำคัญทั้งหมดไว้ในรูปแบบที่ Search Engine เข้าใจได้ง่าย ไฟล์นี้ทำหน้าที่บอก Google ว่าเว็บไซต์ของคุณมีหน้าอะไรบ้าง และหน้าใดควรถูกนำไปเก็บข้อมูล แล้วการมี Sitemap.xml ช่วยให้ Google เข้าใจเว็บไซต์ได้อย่างไร

- ช่วยให้ Google พบหน้าเว็บได้ครบถ้วน: Sitemap.xml ทำให้ Googlebot รู้จักหน้าเว็บทั้งหมดที่คุณต้องการให้เก็บข้อมูล แม้บางหน้าจะไม่มีลิงก์เชื่อมโยงจากหน้าอื่นก็ตาม ช่วยลดโอกาสที่หน้าเว็บสำคัญจะถูกมองข้าม โดยเฉพาะในเว็บไซต์ขนาดใหญ่หรือเว็บที่เพิ่งเปิดใหม่

- ช่วยบอกโครงสร้าง และความสำคัญของหน้าเว็บ: ภายใน xml สามารถระบุข้อมูลเพิ่มเติม เช่น วันที่อัปเดตล่าสุดหรือความสำคัญของหน้าแต่ละหน้า ทำให้ Google เข้าใจโครงสร้างเว็บไซต์ได้ดีขึ้น และรู้ว่าหน้าใดควรถูกตรวจสอบหรืออัปเดตก่อน

- ช่วยให้การเก็บข้อมูล และทำดัชนีรวดเร็วขึ้น: เมื่อ Google มีแผนที่เว็บไซต์ที่ชัดเจน บอทจะใช้เวลาน้อยลงในการสำรวจเว็บไซต์ ส่งผลให้หน้าใหม่หรือหน้าที่มีการแก้ไข มีโอกาสถูกนำไปแสดงบนผลการค้นหาได้เร็วขึ้น

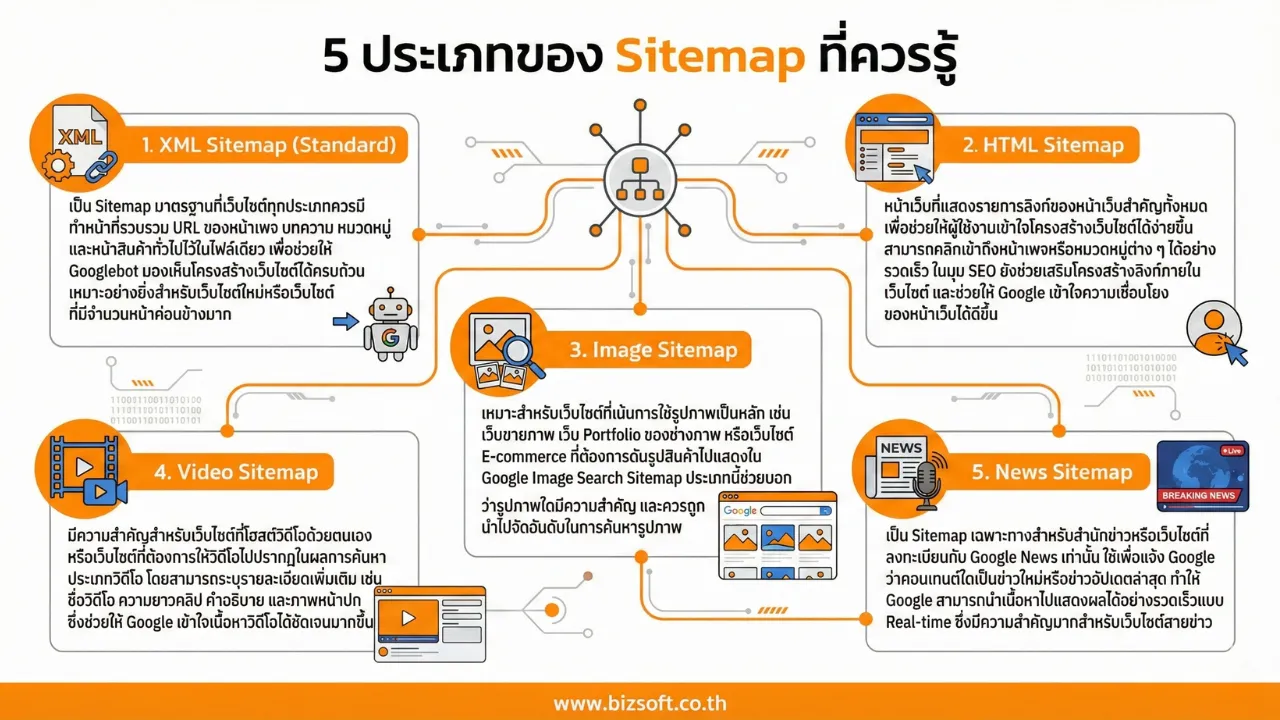

5 ประเภทของ Sitemap ที่ควรรู้

- XML Sitemap (Standard): เป็น Sitemap มาตรฐานที่เว็บไซต์ทุกประเภทควรมี ทำหน้าที่รวบรวม URL ของหน้าเพจ บทความ หมวดหมู่ และหน้าสินค้าทั่วไปไว้ในไฟล์เดียว เพื่อช่วยให้ Googlebot มองเห็นโครงสร้างเว็บไซต์ได้ครบถ้วน เหมาะอย่างยิ่งสำหรับเว็บไซต์ใหม่หรือเว็บไซต์ที่มีจำนวนหน้าค่อนข้างมาก

- HTML Sitemap: หน้าเว็บที่แสดงรายการลิงก์ของหน้าเว็บสำคัญทั้งหมด เพื่อช่วยให้ผู้ใช้งานเข้าใจโครงสร้างเว็บไซต์ได้ง่ายขึ้น สามารถคลิกเข้าถึงหน้าเพจหรือหมวดหมู่ต่าง ๆ ได้อย่างรวดเร็ว ในมุม SEO ยังช่วยเสริมโครงสร้างลิงก์ภายในเว็บไซต์ และช่วยให้ Google เข้าใจความเชื่อมโยงของหน้าเว็บได้ดีขึ้น

- Image Sitemap: เหมาะสำหรับเว็บไซต์ที่เน้นการใช้รูปภาพเป็นหลัก เช่น เว็บขายภาพ เว็บ Portfolio ของช่างภาพ หรือเว็บไซต์ E-commerce ที่ต้องการดันรูปสินค้าไปแสดงใน Google Image Search Sitemap ประเภทนี้ช่วยบอก Google ว่ารูปภาพใดมีความสำคัญ และควรถูกนำไปจัดอันดับในการค้นหารูปภาพ

- Video Sitemap: มีความสำคัญสำหรับเว็บไซต์ที่โฮสต์วิดีโอด้วยตนเอง หรือเว็บไซต์ที่ต้องการให้วิดีโอไปปรากฏในผลการค้นหาประเภทวิดีโอ โดยสามารถระบุรายละเอียดเพิ่มเติม เช่น ชื่อวิดีโอ ความยาวคลิป คำอธิบาย และภาพหน้าปก ซึ่งช่วยให้ Google เข้าใจเนื้อหาวิดีโอได้ชัดเจนมากขึ้น

- News Sitemap: เป็น Sitemap เฉพาะทางสำหรับสำนักข่าวหรือเว็บไซต์ที่ลงทะเบียนกับ Google News เท่านั้น ใช้เพื่อแจ้ง Google ว่าคอนเทนต์ใดเป็นข่าวใหม่หรือข่าวอัปเดตล่าสุด ทำให้ Google สามารถนำเนื้อหาไปแสดงผลได้อย่างรวดเร็วแบบ Real-time ซึ่งมีความสำคัญมากสำหรับเว็บไซต์สายข่าว

วิธีสร้าง Sitemap.xml สำหรับมือใหม่

1. สร้าง Sitemap.xml ผ่านระบบ CMS

หากเว็บไซต์สร้างด้วย WordPress วิธีที่ง่ายที่สุดคือใช้ปลั๊กอิน SEO เช่น Yoast SEO หรือ Rank Math ระบบจะสร้าง Sitemap.xml ให้อัตโนมัติทันทีโดยไม่ต้องเขียนโค้ดเพิ่มเติม เมื่อมีการเพิ่มหรือแก้ไขหน้าเว็บ Sitemap จะอัปเดตตามแบบเรียลไทม์ ช่วยลดความผิดพลาด และเหมาะกับผู้เริ่มต้นมากที่สุด

2. สร้าง Sitemap.xml ด้วยเครื่องมือออนไลน์

สำหรับเว็บไซต์ที่ไม่ได้ใช้ CMS สามารถใช้เครื่องมือสร้าง Sitemap ออนไลน์ได้ เพียงกรอก URL เว็บไซต์ ระบบจะสแกนหน้าเว็บ และสร้างไฟล์ Sitemap.xml ให้ทันที วิธีนี้ใช้งานง่าย และไม่ต้องติดตั้งอะไรเพิ่ม แต่ต้องสร้างใหม่ทุกครั้งเมื่อมีการเพิ่มหน้าเว็บ เหมาะกับเว็บไซต์ขนาดเล็กหรือเว็บที่ไม่ค่อยมีการอัปเดตมากนัก

3. สร้าง Sitemap.xml ด้วยตนเอง

วิธีนี้คือการเขียนไฟล์ XML ด้วยตนเอง โดยใส่ URL ของหน้าเว็บที่ต้องการให้ Google เก็บข้อมูล ข้อดีคือสามารถควบคุมรายละเอียดได้ทั้งหมด แต่ใช้เวลามาก และมีโอกาสผิดพลาดสูง หากเขียนโครงสร้างไม่ถูกต้อง Google อาจไม่อ่านไฟล์ จึงไม่แนะนำสำหรับมือใหม่ที่ยังไม่มีพื้นฐานด้านเทคนิค

ความแตกต่างระหว่าง Robots.txt และ Sitemap.xml

ข้อควรระวังในการใช้งาน Robots.txt และ Sitemap.xml

Robots.txt และ Sitemap.xml เป็นไฟล์พื้นฐานที่ทำหน้าที่ควบคุม และช่วยอำนวยความสะดวกให้ Google เข้าใจเว็บไซต์ได้อย่างถูกต้อง Robots.txt ใช้กำหนดว่าบอทควรหรือไม่ควรเข้าไปเก็บข้อมูลในส่วนใดของเว็บไซต์ ขณะที่ Sitemap.xml ทำหน้าที่รวบรวมหน้าเว็บสำคัญทั้งหมดเพื่อบอกโครงสร้างเว็บไซต์ให้ Google รับรู้ หากตั้งค่าไฟล์ใดไฟล์หนึ่งผิดพลาด อาจทำให้หน้าเว็บสำคัญไม่ถูกเก็บข้อมูลหรือไม่ติดอันดับได้ การใช้งานทั้งสองไฟล์ควรทำควบคู่กันอย่างรอบคอบ และตรวจสอบสม่ำเสมอผ่าน Google Search Console เพื่อให้การทำ SEO อย่างมีประสิทธิภาพ

สรุป มือใหม่ควรเริ่มจัดการ Robots.txt และ Sitemap.xml อย่างไรดี

มือใหม่ควรเริ่มจากการตั้งค่า Robots.txt และ Sitemap.xml ให้เรียบง่ายและถูกต้องตามพื้นฐาน ไม่จำเป็นต้องปรับแต่งซับซ้อนตั้งแต่แรก ควรตรวจสอบให้แน่ใจว่า Robots.txt ไม่ได้ปิดกั้นหน้าเว็บสำคัญโดยไม่ตั้งใจ และ Sitemap.xml มีเฉพาะหน้าที่ต้องการให้ Google นำไปทำดัชนี เมื่อเว็บไซต์มีการเพิ่มหรือปรับปรุงเนื้อหา ควรอัปเดตไฟล์เหล่านี้ควบคู่กันเสมอ การดูแลอย่างสม่ำเสมอจะช่วยให้ Google เข้าใจเว็บไซต์ได้ดีขึ้น และเป็นพื้นฐานสำคัญของการทำ SEO

หากต้องการคำแนะนำจากผู้เชี่ยวชาญเพื่อช่วยตรวจสอบ และจัดการโครงสร้างเว็บไซต์ให้เหมาะสมกับการทำ SEO พวกเรา Bizsoft พร้อมให้คำปรึกษา และดูแลด้านโครงสร้างเว็บไซต์ รวมถึงการตั้งค่า Robots.txt และ Sitemap.xml อย่างเหมาะสม เพื่อให้เว็บไซต์พร้อมสำหรับการทำงานกับ Google ได้อย่างถูกต้อง ติดต่อเข้ามาได้เลย ยินดีให้คำปรึกษาฟรี!